GPT локально на домашнем компьютере

Несколько лет назад я экспериментировал с созданием нейросети, которая сможет генерировать тексты. На тот момент еще самый популярный способ решить такую задачу – рекуррентные сети. А конкретно – LSTM (long short-term memory).

Учитывая серьезные временные затраты на обучение нейронки (а каждое обучение занимало несколько суток непрерывного “гудения компьютера”), приходилось максимально качественно готовить данные, на которых я ее обучал.

Для получения обучающего датасета я парсил книжки и парсил сайты. Упрощал все, что только можно. Убирал слишком сложные и длинные предложения, где много знаков препинания, убирал предложения, в которых был слишком высокий процент редких слов. Даже хотел все виды имен собственных заменять каким-то одним (в правильном падеже). Пробовал и тематикой ограничить (обучать на чисто футбольных текстах).В общем, после обучения нейросеть могла что-то из себя выдавить более-менее связное. Но это было лишь забавно. :)

Было очевидно, что у меня не хватит никаких мощностей для обучения нормальной модели. Ни для подготовки такого объема и качества обучающих данных, ни для тренировки сети. Помню, где-то читал про затраты в миллионах долларов на аренду мощностей для обучения.

А сегодня на хайпе (в хорошем смысле этого слова) уже нейросети-трансформеры, которые намного лучше подходят под это дело, чем LSTM. Уже сегодняшние возможности трансформеров на примере chatGPT (GPT=generative pre-trained transformer) от OpenAI поражают воображение.Ну ладно уже с этим обучением, но неужели и использование готовой модели локально на домашнем компьютере так и останется недоступным? Неужели наш удел – лишь пользоваться различными облачными сервисами?

А вот и нет! Разработчики из Stanford University решили подлить масла в этот котел хайпа. :) И выложили в публичный доступ свою языковую модель: https://simonwillison.net/2023/Mar/13/alpaca/

Без специального дообучения (как дообучали chatGPT) модель умеет пока просто писать тексты (т.е. продолжать по смыслу). Но, как утверждают авторы, файн-тюнинг этой модели вполне доступен финансово.

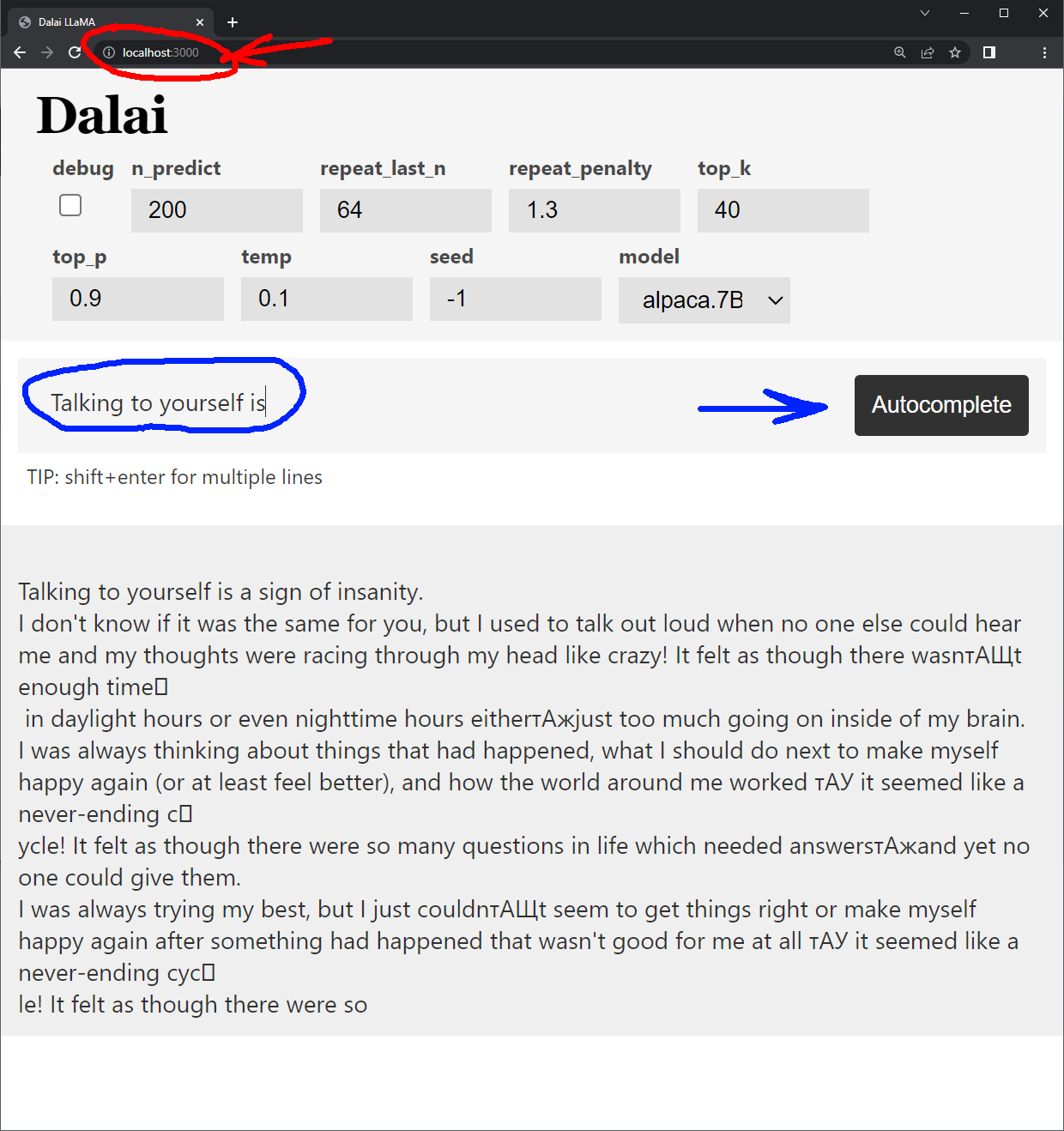

Ради интереса, попробовал локально пощупать самую упрощенную/обрезанную версию этой нейронки на 4 гигабайта. Работает! :)

Теперь можно даже локально “подружить” Dalai LLama и Stable Diffusion, чтобы первая книжку писала, а вторая генерировала к ней иллюстрации. :) И все это без всякого интернета.